Per ricordare David Wessel, scomparso il 13 Ottobre a 73 anni, mettiamo alcune testimonianze.

Per ricordare David Wessel, scomparso il 13 Ottobre a 73 anni, mettiamo alcune testimonianze.

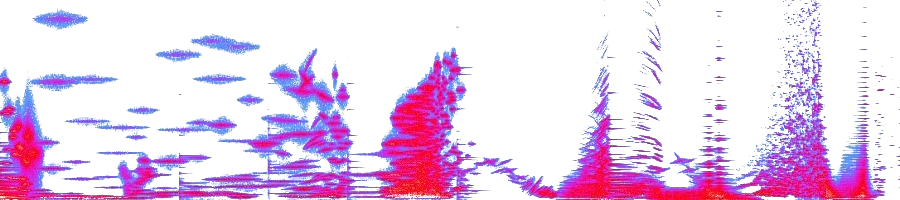

Per primo, il suo brano del 1977, Anthony.

In realtà Wessel è sempre stato un ricercatore più che un compositore, difatti la sua produzione musicale è rara. Anthony è un tipico brano costruito con fasce sonore in dissolvenza incrociata ed è stato uno dei primi pezzi realizzati con le macchine per la sintesi in tempo reale costruite da Peppino Di Giugno all’IRCAM.

Quella utilizzata qui è la 4A del 1975, uno dei primi modelli, il primo ad andare oltre lo stadio di prototipo. Si trattava di un processore capace di generare in tempo reale fino a 256 oscillatori digitali in wavetable (cioè con forma d’onda memorizzata e quindi con contenuto armonico definito dall’utente) con relativo inviluppo di ampiezza. Nonostante il fatto che gli oscillatori non si potessero connettere fra loro, era un passo avanti notevole per quegli anni perché, con i sistemi analogici dell’epoca, era già difficile arrivare a 10 oscillatori (per maggiori particolari vedi le voci 4A e Giuseppe Di Giugno sul blog di Alex Di Nunzio).

Se da punto di vista quantitativo la 4A era un grande passo avanti, la qualità del suono era limitata dal fatto che non si potevano realizzare dei metodi di sintesi a spettro sonoro variabile (per es. con filtri o modulazione di frequenza), se non ricorrendo all’additiva. In Anthony, Wessel aggira questo limite evitando una caratterizzazione melodica del materiale sonoro, affidandosi, invece, a grandi cluster in lenta mutazione armonica.

Att.ne: il brano inizia molto piano. Inoltre con gli altoparlantini del computer ne sentite metà.

Un secondo contributo video riguarda l’attività di David Wessel come ricercatore interessato principalmente all’interazione uomo – macchina, tanto che nel 1985 aveva fondato all’IRCAM un dipartimento di ricerca dedicato allo sviluppo di software musicale interattivo.

Qui viene mostrato lo SLAB, uno dispositivo di controllo composto da una serie di touch pad sensibili alla posizione e alla pressione. Ogni pad trasmette al computer informazioni relative alla posizione xy del dito che lo preme e alla pressione esercitata. Il flusso di dati è ethernet, non MIDI, per cui le misure sono accurate e la risposta è veloce (questa storia del superamento del MIDI ce la porteremo dietro per la vita; per citare Philip Dick, la cavalletta ci opprime). Maggiori dati tecnici sullo SLAB, qui. Per gli impazienti, nel video la performance inizia a 2:40.